Odpowiem w punktach.

Po pierwsze wiele połączeń w telefonii komórkowej nadal jest realizowanych przez sieć 2G *). Wywodzi się ona z początków cyfrowej telefonii komórkowej. Wobec mocy obliczeniowej dzisiejszych komputerów (przestarzały algorytm szyfrujący) oraz prostoty ataków (użycie fałszywej stacji bazowej wykorzystujące brak uwierzytelnienia sieci przez telefon), można powiedzieć, że GSM nie zapewnia już ani poufności, ani bezpieczeństwa przed atakami na poziomie zorganizowanej grupy hakerskiej. Wobec graczy sponsorowanych przez agencje rządowe obcych krajów GSM jest całkowicie bezbronny.

Po drugie przy komunikacji międzyoperatorskiej używany jest protokół SS7, którego słabości są powszechnie znane. Ten protokół nie był projektowany pod kątem bezpieczeństwa transmisji, ale oczekiwanej funkcjonalności. Dopiero teraz operatorzy wprowadzają zabezpieczenia, które mają na celu odfiltrowanie niepoprawnych komunikatów wymienianych tą drogą. O skali problemu opowiadali specjaliści Orange podczas dzisiejszego wystąpienia na konferencji Advanced Threat Summit:

Pragnę zwrócić uwagę na to, że krajem, z którego pochodziło najwięcej najbardziej różnorodnych błędnych lub fałszywych komunikatów SS7 kierowanych do urządzeń w sieci Orange (globalnego, także francuskiego) za pomocą SS7 była Wielka Brytania. Ataków z Rosji lub USA było bardzo mało.

Jak to wygląda przy klasycznej telefonii lub dobrze wdrożonym VoIP? Gdy spytałem o skalę problemu w sieciach stacjonarnych otrzymałem odpowiedź, cytuję:

- większość omawianych zagrożeń w SS7 dotyczy mobilności użytkownika, zatem nie są one tak istotne w sieciach stacjonarnych.

Zatem stary telefon stacjonarny nie jest wcale taki zły. Dodatkowa lektura podsumowująca z konferencji BlackHat z 2001r (!) - uwaga na plik pptx.

Po trzecie telefon stacjonarny ma dodatkową zaletę - emisja promieniowania elektromagnetycznego ze słuchawki na kablu wynosi zero. Tak jest. SAR=0W/kg. Telefony bezprzewodowe DECT należy traktować tak samo, jak komórkowe, nawet jeśli emisja samej słuchawki deklarowana przez producenta jest stosunkowo niewielka. Obok siebie masz przecież bazę, która nadaje prawie cały czas (wyjątek: stacje Gigaset przełączone w odpowiedni tryb pracy).

Dodatkowo telefony stacjonarne też mają swój urok. Solidny, stary kawał elektrotechniki.

Na zdjęciu - interkom (czyli telefon wewnętrzny) używany na okręcie podwodnym.

*) wyjątkiem jest Japonia. Tam nie ma już sieci 2G. W kwietniu przyszłego roku sieci GSM wyłączone będą w Singapurze. Mimo to nadal możemy się spodziewać długiego wykorzystywania 2G. Jak podaje GSM Alliance nadal 58,5% połączeń na świecie wykonuje się właśnie z sieci GSM/2G, a 32,5% - z sieci UMTS/3G. Eksperci uważają, że 2G będzie dominującą technologią aż do roku 2019. Użytkownicy Nokii 6310i mogą spać spokojnie jeszcze przez kilka lat.

środa, 23 listopada 2016

piątek, 18 listopada 2016

Miniaturyzacja i postęp techniki

Dziś zostałem poproszony o podanie przykładu, który dobitnie przedstawi postęp techniki. Chyba najbardziej oczywistym przykładem będzie centrala telefoniczna. Oto pomieszczenie centrali #Pentaconta #PC1000C w Wałbrzychu przy ul. Długiej.

Niestety PC1000C nie można obejrzeć nawet w muzeum, bo żadna taka centrala nie zachowała się w kraju. Wszystkie zostały zezłomowane na przełomie wieków, gdy ostatecznie pożegnaliśmy elektromechaniczną komutację w sieci TPSA. Centrala Pentaconta była szczytem możliwości elektromechanicznej komutacji. Archiwalne zdjęcia można obejrzeć na tej stronie.

A tutaj pożegnanie małej centrali tego systemu, zlokalizowanej w Leszczynach:

Obecnie z telefonami VoIP dla tej liczby abonentów poradzi sobie Asterisk na moim laptopie. Centrale,

którymi dziś administruję obsługują o wiele więcej numerów niż wałbrzyska PC1000C i wszystkie razem

mogłyby się zmieścić w jednej szafie przemysłowej. Nie będę wstawiać zdjęć, mogę tylko powiedzieć, że jest to klaster standardowych rackowych serwerów jednego z najważniejszych producentów w branży.

Tylko tak zwanego "telewizorka" z lampkami nie ma. Klimat nie ten.

Źródło - jest tu.

niedziela, 13 listopada 2016

Historia rewolucji w druku

Jedną z dziedzin techniki, która uległa tak znaczącym zmianom w miarę rozwoju elektroniki był druk. Cała ta rewolucja w druku zaczęła się w latach siedemdziesiątych i ostatecznie zakończyła w latach dziewięćdziesiątych. Miejsce składu ręcznego (ręczne umieszczanie czcionek w wierszowniku) i maszynowego gorącego (np. odlewanie całego wiersza na linotypie) zajął skład komputerowy w edytorze tekstu, a następnie łamanie za pomocą oprogramowania komputerowego. Rewolucja ta spowodowała niemal całkowity zanik typografii, czyli druku bezpośredniego wypukłego z użyciem czcionek. Zaczniemy zatem od typografii.

Kaszty pełne skarbów

Większość publikacji (książki, gazety, ulotki) drukowano z użyciem czcionek. Każda drukarnia miała różne zestawy (kroje, stopnie) czcionek, ale zazwyczaj używano kilku z nich. W odróżnieniu od dzisiejszego oprogramowania, czcionek metalowych, odlanych ze stopu drukarskiego (ołów, antymon, cyna) nie można było skalować i jeden komplet służył do druku konkretnym krojem. |

| Schemat czcionki - Mała Encyklopedia Techniki, 1960r. |

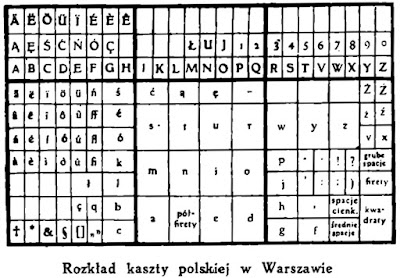

Dziś wystarczy zainstalować font w systemie i można już pracować, ale w czasach ręcznego składu, metalu i farby każdy rodzaj czcionki trzeba było odlać w formach w fabryce (giserni) i dostarczyć do drukarni, gdzie każdą literę czcionki wkładano do kaszty (szuflady), do właściwej przegródki zwanej króbką. Tak umieszczano czcionki w kaszcie warszawskiej:

Warto zwrócić uwagę na to, że przy składzie ręcznym powszechnie stosowano ligatury, czyli dwie litery połączone w jedną (na przykład fi drukowane jak jedna litera, kropka na i łączy się z elementem litery f).

Oto przykładowe rodzaje pisma – cytuję za „Małą Encyklopedią Techniki” z 1960r.

Dziś Antykwa Półtawskiego jest dostępna także w formie elektronicznej. Obecnie antykwę Półtawskiego wykorzystuje się niemal wyłącznie w tytułach oraz niektórych drukach akcydensowych (o niewielkim nakładzie) stylizowanych na druk przedwojenny.

Inne czcionki charakterystyczne dla starszej polskiej typografii można obejrzeć na tej stronie.

Duże, małe...

Rozmiar czcionki, czyli jej stopień określano w punktach – właśnie stąd powstała tak popularna czcionka dwunastka, miała ona rozmiar 12 pkt typograficznych. Tradycyjnie każdy stopień miał swoją nazwę, najmniejsza używana w popularnym druku czcionka miała stopień 6 i nosiła nazwę nonparel. Stąd powstało określenie "napisać nonparelem" - napisać coś bardzo małą czcionką.

Były jeszcze

mniejsze czcionki: perl (5pkt), diamant/diament (4pkt) i brylant

(3pkt) - im mniejsze, tym "droższe". Teraz wiecie dlaczego małą czcionką drukowane są

bardzo ważne informacje w umowach handlowych i bankowych...

Z kaszty do arkusza

Tekst źródłowy,

dostarczony w formie maszynopisu był składany przez zecera z

czcionek pobieranych z kaszty i układanych w wierszowniku (dawniej

zwanym winkelakiem), ustawionym na odpowiednią szerokość.

|

| Skład ręczny, ilustracja z Małej Encyklopedii Techniki, 1960r. |

Wiersze

złożone jeden nad drugim tworzyły kolumnę, a kolejne kolumny –

arkusz. Tekst w wierszach był łamany, czyli tak umieszczany, by

utworzył kolumny o równej szerokości, z miejscem na ilustracje

oraz inne elementy. Puste miejsca wypełniało się pustym tzw. ślepym materiałem

(justunkiem) i całość ściskało w metalowej ramie. Uzupełnieniem wiersza do ostatecznej szerokości był drobny justunek (półfiret, firet, oraz spacje), który również znajdował się w kaszcie. Układem wierszy na stronie zajmował się

doświadczony zecer, nazywany metrampaż (z francuskiego - metteur en pages - składający w strony).

|

| Metrampaż przy pracy. |

Proces składu i

łamania publikacji był niezwykle pracochłonny, sporo było tam

miejsca na ludzki błąd. Po złożeniu tekstu, na prostej prasie

wykonywano odbitkę do korekty, by poprawić ewentualne błędy.

Czasami błędy wychwytywano już po wydrukowaniu nakładu, a wtedy

jedynym sposobem poprawy tego błędu było szybkie wydrukowanie

erraty – spisu błędów razem z ich poprawą. Erratę drukowano na

końcu.

Typografia nie zginęła

Wbrew pozorom mechanizacja ani komputeryzacja nie zabiły całkiem typografii. Ostatnie drukarnie z ręcznym składem działały na pokładzie dalekomorskich statków i w więzieniach jeszcze w latach osiemdziesiątych. Obecnie nadal drukuje się akcydensy z użyciem metalowych czcionek, składanych przez zecera. Są to jednak dzieła, które należy traktować bardziej jako sztukę druku użytkowego niż jako środek publicznej komunikacji.Pierwsza mechanizacja

Niezwykle pracochłonny skład ręczny dość szybko udało się zastąpić składem maszynowym (gorącym), w którym z roztopionego stopu drukarskiego w odpowiedniej maszynie odlewano całe wiersze. Od tego czasu w większych drukarniach skład ręczny stosowano tylko przy drukach akcydensowych, skomplikowanych formułach matematycznych i chemicznych oraz przy trudnych tabelach. Metrampaż jest jednym z zawodów zaginionych, chociaż część wiedzy dobrego zecera posiadają doświadczeni operatorzy DTP. O składzie mechanicznym z użyciem linotypu opowiem w następnym odcinku.niedziela, 6 listopada 2016

Komputer Karpińskiego – fakty i mity

Gdyby porównać

wszystkie komputery kiedykolwiek wyprodukowane w kraju pod względem

mitów narosłych wokół ich konstrukcji, liderem byłby

minikomputer K-202 konstrukcji inżyniera Jacka Karpińskiego. Opisy

te bywają pisane dość martyrologicznym językiem, zawierają

mnóstwo nieścisłości i przekłamań. Nawet etykieta opisująca

komputer w warszawskim Muzeum Techniki ma taki ton. Gdzie zatem może być ta prawda? Odpowiedź jest

prozaiczna – najprędzej znajdziemy ją w Archiwum Akt Nowych, a

także w dokumentach sekcji historycznej Polskiego Towarzystwa

Informatycznego i we wspomnieniach osób, które tworzyły historię

komputerów PRL.

Jaki naprawdę był K-202?

|

| Komputer K-202, zbiory Muzeum Techniki w Warszawie. |

To była maszyna,

która odzwierciedlała światowe trendy i rzeczywiście była

skonstruowana zgodnie z najlepszymi zasadami. Bez wątpienia był to

pierwszy, wręcz pionierski minikomputer w Polsce. Analizy prowadzone

przez kilka komisji, w tym dość słynną komisję Ministerstwa

Przemysłu Maszynowego powołaną przez ministra A. Kopcia oraz

osobny raport A.Kilińskiego potwierdzają to w całej rozciągłości.

To była bardzo dobra maszyna, na światowym poziomie, pierwsza taka

w kraju. Nie oznacza to jednak, że była przełomowa w skali

światowej, bo takie cechy, jak stronicowanie pamięci i praca

wieloprocesorowa, były znane i wykorzystywane od dziesięciu lat.

Nie był to najwydajniejszy komputer w kraju, ale był bardzo

elastyczny i nieźle skalowalny jak na urządzenie tej klasy.

Problematyczna nisza

Niestety komputer J.

Karpińskiego był obarczony ciężkim bagażem niszy

technologicznej, gdyż był maszyną niezgodną z najpopularniejszym

wtedy minikomputerem na świecie: serią PDP-11 firmy Digital

Equipment Corporation. Oczywiście z czasem napisano oprogramowanie

na K-202, ale całość nigdy nie wyszła poza stadium krótkoseryjnej

produkcji. Według bardzo optymistycznych planów J. Karpińskiego

przesłanych w liście do J.Szydlaka w ciągu 5 lat zaplanowano

wyprodukowanie około 2000 tych komputerów. Tymczasem samych PDP-11

wyprodukowano około 600 tysięcy, poprzednia generacja PDP-8

sprzedała się w liczbie 50 tys sztuk. Mówimy tylko o tym jednym

zagranicznym producencie szesnastobitowego komputera. K-202 był

niewątpliwie maszyną dobrą, ale niszową, na którą dopiero

opracowywano nowoczesne oprogramowanie. Sporą część aplikacji

pisano w asemblerze ASSK, dopiero później pojawiły się aplikacje

pisane w FORTRANIE, ALGOLu czy za pomocą MOST-2. Dla porównania –

na PDP-11 napisano mnóstwo oprogramowania, był na niego dostępny

także najpopularniejszy system operacyjny na świecie – UNIX.

Dlaczego K-202 nie podbił kraju?

Wbrew powszechnie

roztaczanym mitom K-202 wcale nie został zniszczony, bo konkurował

wprost z ODRĄ lub RIADem. Konstruktorzy tego komputera wprost

planowali jego współpracę z dużymi maszynami, co oczywiście ma

sens, także z dzisiejszej perspektywy. Przyczyna porażki rynkowej

K-202 była związana z socjalistyczną gospodarką niedoboru i

powszechnymi problemami z dostępnością zasobów, w tym podzespołów

elektronicznych. Proces inwestycyjny był skomplikowany i kosztowny,

a do tego rozległy, bo wymagał budowy osobnego zakładu (nie było

gdzie rozpocząć wielkoskalowej produkcji tego komputera). Ponadto

komputer K-202 został zaprojektowany z użyciem zagranicznych

podzespołów z drugiego obszaru płatniczego. Tak zwany wsad

dewizowy (przypomnę – w tym czasie złotówka nie była walutą

wymienialną, przelicznik zł/USD był bardzo niekorzystny) wynosił 1900 USD na sztukę w przypadku serii informacyjnej, a zatem w

warunkach polskich był to drogi komputer o małych rozmiarach.

|

| Moduł pamięci komputera K-202, jest to płyta firmy Core Memories (USA/Dublin), w module znajdują się układy scalone firmy Motorola. |

Podobnie jak w

przypadku pozostałych maszyn z tej epoki, K-202 wymagał osobnych

urządzeń peryferyjnych, takich jak terminale, napędy taśm

magnetycznych, monitory ekranowe, multipleksery, perforatory i

czytniki taśmy papierowej, przetworniki analogowo-cyfrowe oraz

modemy (w późniejszym etapie). Oczywiście peryferia jeszcze

bardziej podnosiły koszty. Dość często porównywano wsad dewizowy K-202 z kompletną ODRĄ, co jest nie na miejscu, gdyż ODRĘ wdrażano z pojemnymi pamięciami taśmowymi, ponadto do tych komputerów zakupiono także licencje na oprogramowanie, w tym system operacyjny GEORGE - a była to szczególnie mocna strona tego komputera.

Sam K-202, chociaż

mógł działać po dołączeniu terminala wierszowego, pełnię

swoich możliwości pokazywał po integracji z dodatkowymi modułami

i urządzeniami. Przykładowy „zestaw dla prac

projektowo-inżynierskich” (strona czwarta ulotki informacyjnej)

wymagał dołączenia CPU K-202 16k z dwoma modułami RAM 16k oraz

modułami wejścia/wyjścia. W praktyce planowano także o wiele

bardziej skomplikowane instalacje z więcej niż jednym CPU (K-202 był

od początku projektowany pod kątem właśnie takich instalacji).

Oto przykładowy komputer dla automatyzacji pomiarów CAMAC oznaczony znakiem Polon wyposażony w trzy jednostki K-202, dwa moduły pamięci masowej oraz karty do obsługi urządzeń peryferyjnych.

Oto przykładowy komputer dla automatyzacji pomiarów CAMAC oznaczony znakiem Polon wyposażony w trzy jednostki K-202, dwa moduły pamięci masowej oraz karty do obsługi urządzeń peryferyjnych.

|

| Instalacja K-202 w zastosowaniach pomiarowych standardu CAMAC, trzy CPU, dwa moduły pamięci, moduł kart pomiarowych. Zbiory Muzeum Techniki w Warszawie. |

Warto zwrócić

uwagę na wykonanie urządzeń peryferyjnych – jest to sprzęt o

bardzo dobrej konstrukcji mechanicznej, wyprodukowany zgodnie z

najlepszymi zasadami. Śmiem twierdzić, że dzisiejsze konstrukcje

automatyki przemysłowej i niektóre urządzenia laboratoryjne są

zaprojektowane z mniejszą starannością o szczegóły od tego

komputera!

|

| Moduł kart pomiarowych. |

Cięcie kosztów i następca K-202

Po wyprodukowaniu

serii informacyjnej należało niezwłocznie obniżyć koszty.

Zastosowano zatem podzespoły wyprodukowane w kraju, kosztem znacznie

większych rozmiarów całego komputera i urządzeń peryferyjnych.

Powstała w ten sposób maszyna MERA 400 mogła współpracować z

większymi komputerami, takimi jak Odra (na licencji ICL) oraz RIAD

(który de facto był mainframem zgodnym z IBM 360, zbudowanym w

krajach RWPG na podstawie ogólnie dostępnej dokumentacji firmy

IBM *) ). Komputery tej serii, wyposażone w sporo kart rozszerzeń

pracowały przy automatyce przemysłowej przez następne dwie lub

nawet cztery dekady. W piśmie z 30.12 2014 nadesłanym do Jarosława

Krawczyka (red. naczelny periodyku Mówią Wieki), Jerzy S. Nowak

pisze o komputerach MERA 400, że „są urządzenia pracujące do

dziś”. Duch i pomysł J. Karpińskiego wcale nie zaginął, jego

konstrukcja również.

Non omnis moriar

Idee Jacka

Karpińskiego znalazły odzwierciedlenie w innym komputerze, który

zyskał pewną popularność. Był nim następca K-202, czyli MERA

400. Komputer ten został przekonstruowany tak, by użyć jak

najwięcej podzespołów krajowej produkcji. Opracowano także nowe

peryferia, rozpoczęto prace nad możliwie szybkim opracowaniem

różnego oprogramowania użytkowego dla tej platformy. Niektóre

egzemplarze pracowały ponad 40 lat, szczególnie przy automatyzacji

różnych pomiarów w standardzie CAMAC (IEEE 583).

|

| Pulpit sterowania komputera MERA 400. Widać wyraźne podobieństwo do K-202. |

*) Epoka Gierka była jedynym okresem w PRL, gdy kupowaliśmy, wdrażaliśmy i eksploatowaliśmy najnowsze komputery produkowane w tym czasie przez firmę IBM. Oprócz później produkowanych maszyn RIAD, w polskich firmach działały komputery IBM. Były to najnowsze modele razem z dobrym oprogramowaniem. Były kosztowne, ale na pewno był to opłacalny zakup. Polecam lekturę tekstu, który napisałem dwa lata temu: "Gdy w PRL były najnowsze mainframe'y".

Subskrybuj:

Posty (Atom)